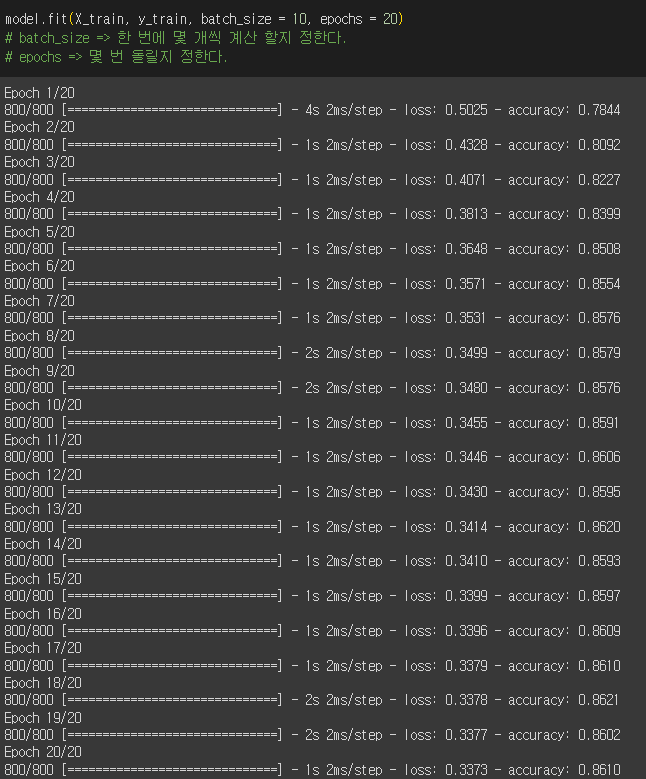

모델링 전 데이터 전처리부터 한다. 1. 데이터 확인 import pandas as pd import numpy as np import matplotlib.pyplot as plt import seaborn as sns # 데이터 통계 확인 >>> df.describe() # nan값 확인 >>> df.isna().sum() # 학습을 위해 X,y값 지정 >>> X = df.loc[ : , '컬럼' : '컬럼' ] >>> y = df['컬럼'] 2. 피처 스케일링 from sklearn.preprocessing import MinMaxScaler # X값 피처스케일링 >>> scaler_X = MinMaxScaler() >>> X = scaler_X.fit_transform(X.values) # y값 피..